Künstliche Intelligenz (KI) bringt rasend schnell Innovationen in viele Branchen, aber KI birgt auch große Gefahren. Daher hat die EU am 1. August 2024 den Artificial Intelligence Act (AI Act) verabschiedet, um einen rechtlichen Rahmen für alle Marktteilnehmer zu schaffen.

Der AI Act wurde eingeführt, um potenzielle Risiken der künstlichen Intelligenz zu minimieren, hierbei geht es primär um Diskriminierung und Manipulation, z.B.

- KI Ergebnisse aus voreingenommenen Datensätzen, den sogenannten KI Bias. Beispielsweise sind das geschlechterspezifische oder rassenspezifische Berufe und Tätigkeiten, die so antrainiert diese Merkmale in KI unterstützen Bewerbungssystemen anwenden. Aber auch eine Kreditbeurteilung, wenn ein Mensch in einem ärmeren Stadtviertel lebt.

- Wenn KI genutzt wird, um Menschen zu manipulieren oder zu täuschen.

- Wenn KI für die unrechtmäßige Überwachung von Menschen genutzt wird.

Für wen gilt der AI Act?

Der AI Act unterscheidet sechs Gruppen von Akteuren, für die der AI Act anzuwenden ist:

- Anbieter – Entwickeln KI-Systeme und bringen diese unter eigenem Namen auf den Markt

- Betreiber – Nutzen KI-Systeme oder integrieren diese in interne Prozesse innerhalb der EU

- Produkthersteller – Bieten KI-Anwendungen oder vertreiben diese unter eigenem Namen in der EU, auch wenn dies nur ein Bestandteil eines Produktes ist.

- Bevollmächtigte – In der EU niedergelassene Vertreter von ausländischen KI-Anbietern (siehe 1.)

- Einführer – diese bringen KI-Systeme von ausländischen KI-Anbietern auf den EU Markt

- Händler – vertreiben KI-Produkte an Unternehmen oder Endnutzer in der EU

Unser Artikel fokussiert sich auf die Anforderungen und Pflichten der Betreiber, also alle Unternehmen die bestehende KI-Systeme nutzen oder in interne Prozesse integrieren. Dazu zählt auch, wenn ein KMU Unternehmen die Nutzung von ChatGPT oder Microsoft Copilot duldet und die MitarbeiterInnen diese selbstständig in ihre tägliche Arbeit integrieren.

Definition des Begriffes „Betreiber“ im AI Act:

„Betreiber“ eine natürliche oder juristische Person, Behörde, Einrichtung oder sonstige Stelle, die ein KI-System in eigener Verantwortung verwendet, es sei denn, das KI-System wird im Rahmen einer persönlichen und nicht beruflichen Tätigkeit verwendet.

Achtung! Ein Unternehmen wird nicht erst zum Betreiber, wenn man ein KI-System selbst „betreibt“, sondern auch wenn man bereitgestellte KI-Systeme z.B. in der Cloud nutzt.

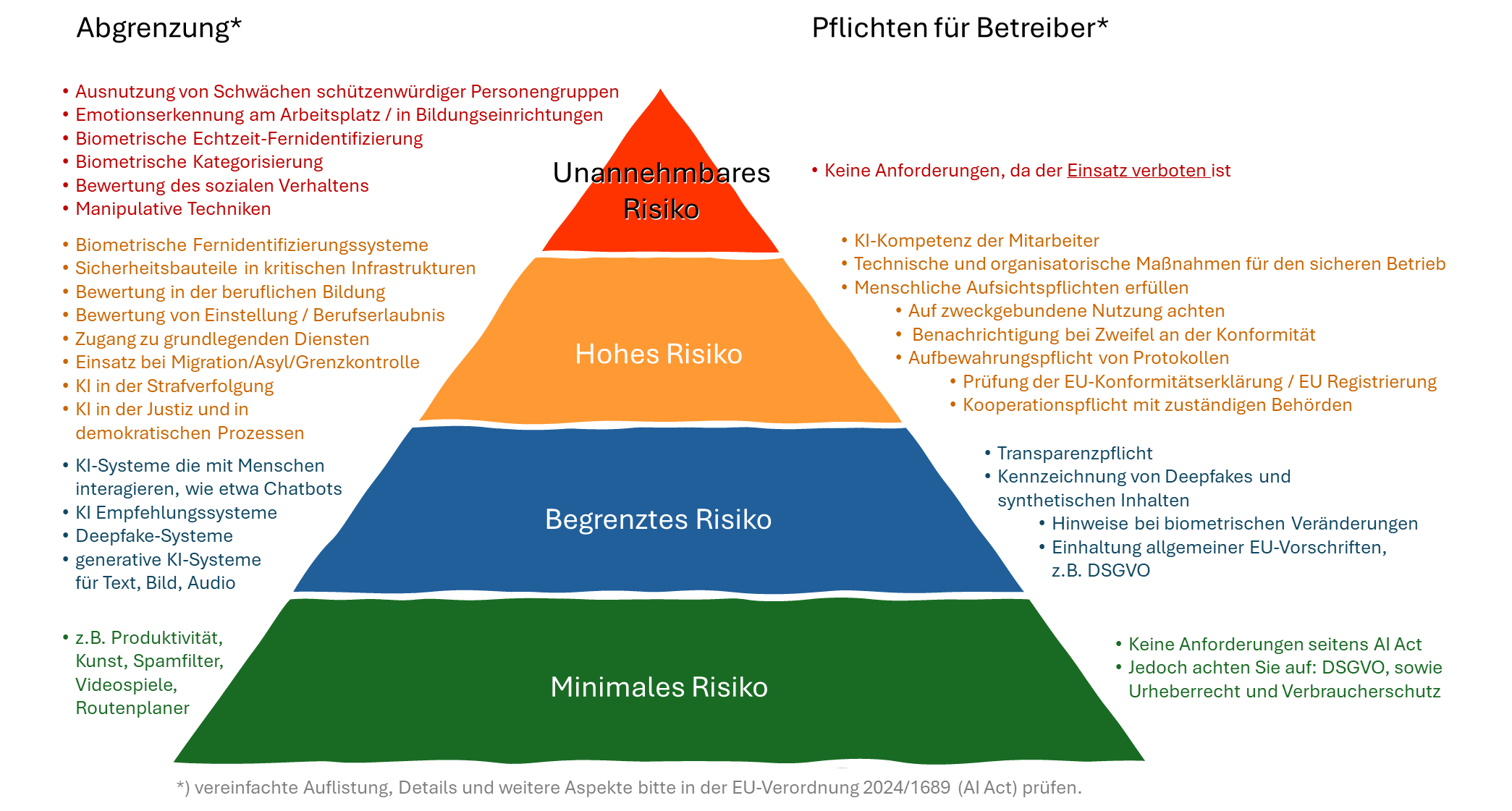

Was genau sind die verbotenen KI-Anwendungen?

Der Artikel 5 des AI Acts regelt die verbotenen Praktiken im KI-Bereich, dazu zählen KI-Systeme die:

- unterschwellige Beeinflussung oder manipulative Techniken nutzen, um das Verhalten von Personen wesentlich zu verändern und mit hinreichender Wahrscheinlichkeit ein erheblicher Schaden zugefügt wird,

- schutzbedürftige Personen oder Gruppen ausnutzen oder einen erheblichen Schaden zufügen,

- eine Schlechterstellung oder Benachteiligung von Personen aufgrund ihres sozialen Verhaltens, ihrer persönlichen Eigenschaften oder ihrer Persönlichkeitsmerkmale bringen,

- eine Profilierung von Personen in Bezug auf die mögliche Begehung von Straftaten durchführt,

- Datenbanken zur Gesichtserkennung aus dem Internet oder aus Überwachungsaufnahmen erstellt,

- Ableitung von Emotionen von Personen am Arbeitsplatz oder Bildungseinrichtungen durchführt,

- Eine biometrische Kategorisierung von Personen aufgrund von biometrischen Daten, der Rasse, der politischen Einstellung, ihrer Gewerkschaftszugehörigkeit, ihrer religiösen oder weltanschaulichen Überzeugung, ihres Sexuallebens oder sexuelle Ausrichtung ermöglichen,

- eine biometrische Echtzeit-Fernidentifikation in öffentlich zugänglichen Räumen ermöglichen,

Einige der verbotenen Praktiken haben Ausnahmen z.B. bei medizinischen Gründen oder für die Strafverfolgung.

Welche KI-Systeme fallen unter die Hochrisiko-KI?

Im Artikel 6 des AI Acts sind die Anwendungen zur Einstufung als Hochrisiko-KI-System definiert:

- KI-Systeme die als Sicherheitsbaustein in Produkte fallen, die im Anhang I des AI Acts gelistet sind, hier geht es i.d.R. um Gefahren für Leib und Leben [Art. 6 (1) a) und b)]

- Biometrische Fernidentifizierungssysteme

- Biometrische Kategorisierung nach sensiblen oder geschützten Attributen oder Merkmalen

- KI-Systeme zur Emotionserkennung

- Einsatz als Sicherheitsbauteil in kritischen Infrastrukturen des Straßenverkehrs, Wasser‑, Gas‑, Wärme- oder Stromversorgung

- Für die allgemeine oder berufliche Bildung in einer Vielzahl an Anwendungsbereichen

- Für die Bewertung von Einstellungen, Beschäftigung, Personalmanagement und dem Zugang zur Selbstständigkeit

- Zugang und Inanspruchnahme von grundlegenden Diensten und Leistungen, u.a. Unterstützungsleistungen, Gesundheitsdiensten, Kreditwürdigkeit, Bonitätsbewertung, Bewertung von Lebens- und Krankenversicherungen, Bewertung von Notrufen

- KI-Systeme für die Strafverfolgung

- beim Einsatz für Migration, Asyl und Grenzkontrolle

- in Einsatz für die Rechtspflege (Justizbehörde) und demokratischen Prozessen wie Wahrverhalten und Wahrrecht

Die Details und mögliche Ausnahmen sind dem Artikel 6 des AI Acts zu entnehmen.

Es gibt sehr hohe Anforderungen für Betreiber von Hochrisiko-KI. Die Anforderungen sind im Artikel 26 „Pflichten der Betreiber von Hochrisiko-KI-Systemen“ des AI Acts gelistet. Hierzu zählen unter anderem:

- Verwendung gemäß Anleitung

- Risikomanagement und Kontrolle

- Aufzeichnungspflichten

- Verpflichtung zur menschlichen Aufsicht

- Schulung des Personals

- Protokollierung (zumind. 6 Monate)

- Meldung von Vorfällen an die zuständigen nationalen Behörden

Transparenzpflichten – Beispiele für KI-Systeme mit begrenztem Risiko

Der Artikel 50 „Transparenzpflichten für Anbieter und Betreiber bestimmter KI-Systeme“ listet zahlreiche Anforderungen auch für die Betreiber. Hier einige Beispiele:

Artikel 50 (4) Betreiber eines KI-Systems, das Bild‑, Ton- oder Videoinhalte erzeugt oder manipuliert, die ein Deepfake sind, müssen offenlegen, dass die Inhalte künstlich erzeugt oder manipuliert wurden.

Wobei „Deepfakes“ im AI Act nicht unmittelbar negativ belegt sind:

„Deepfake“ einen durch KI erzeugten oder manipulierten Bild‑, Ton- oder Videoinhalt, der wirklichen Personen, Gegenständen, Orten, Einrichtungen oder Ereignissen ähnelt und einer Person fälschlicherweise als echt oder wahrheitsgemäß erscheinen würde;

Für Informationen mit öffentlichem Interesse gibt es eine weitere Transparenzregel:

Artikel 50 (4) Betreiber eines KI-Systems, das Text erzeugt oder manipuliert, der veröffentlicht wird, um die Öffentlichkeit über Angelegenheiten von öffentlichem Interesse zu informieren, müssen offenlegen, dass der Text künstlich erzeugt oder manipuliert wurde.

Was sind GPAI (General-Purpose AI) Systeme und was ist dabei zu beachten?

Laut EU AI Act bezeichnet GPAI ein KI-System, das für eine Vielzahl von Aufgaben einsetzbar ist – nicht auf eine spezifische Anwendung beschränkt. Es kann für unterschiedliche Zwecke angepasst oder weiterentwickelt werden.

Beispiele:

- Große Sprachmodelle (wie GPT‑4, Claude, Gemini etc.)

- Bildgenerierungsmodelle (z.B. DALL·E, Midjourney)

- Multimodale KI-Systeme (Text, Bild, Video kombiniert)

- Basismodelle, auf denen viele nachgelagerte KI-Anwendungen aufbauen

Diese Modelle haben ein hohes Potenzial, weitreichende Auswirkungen auf die Demokratie & Meinungsbildung (z.B. Desinformation), auf wirtschaftliche Machtverhältnisse, sowie auf Sicherheit, Grundrechte und gesellschaftliche Prozesse. Der Gesetzgeber will daher sicherstellen, dass diese Systeme verantwortungsvoll trainiert und nicht missbraucht werden können, sowie transparent sind.

Das neue EU AI Office (Teil der Europäischen Kommission) übernimmt die Aufsicht über GPAI-Modelle, insbesondere jene mit systemischem Risiko. GPAI Systeme und deren Anforderungen für Anbieter sind nicht Teil dieses Artikels.

Müssen alle Mitarbeiter die KI nutzen eine KI-Kompetenzschulung machen?

Im Rahmen der EU-KI-Verordnung – dem AI Act – ist eine KI-Kompetenzschulung verpflichtend für alle Anbieter und Betreiber von KI-Systemen. Diese Schulung ist ein zentraler Bestandteil der Anforderung an Betreiber, speziell in Hinblick auf den sicheren, rechtskonformen und ethischen Einsatz.

Definiert ist die KI-Kompetenz in Artikel 4:

Die Anbieter und Betreiber von KI-Systemen ergreifen Maßnahmen, um nach besten Kräften sicherzustellen, dass ihr Personal und andere Personen, die in ihrem Auftrag mit dem Betrieb und der Nutzung von KI-Systemen befasst sind, über ein ausreichendes Maß an KI-Kompetenz verfügen, wobei ihre technischen Kenntnisse, ihre Erfahrung, ihre Ausbildung und Schulung und der Kontext, in dem die KI-Systeme eingesetzt werden sollen, sowie die Personen oder Personengruppen, bei denen die KI-Systeme eingesetzt werden sollen, zu berücksichtigen sind.

Zusätzlich gibt es eine weitere Schulungsanforderungen bezogen auf die menschliche Aufsicht. Geregelt ist diese in Artikel 26 (2) des AI Acts, jedoch gilt diese Pflicht nur für Betreiber von Hochrisiko-KI-Systemen.

Die Betreiber übertragen natürlichen Personen, die über die erforderliche Kompetenz, Ausbildung und Befugnis verfügen, die menschliche Aufsicht und lassen ihnen die erforderliche Unterstützung zukommen.

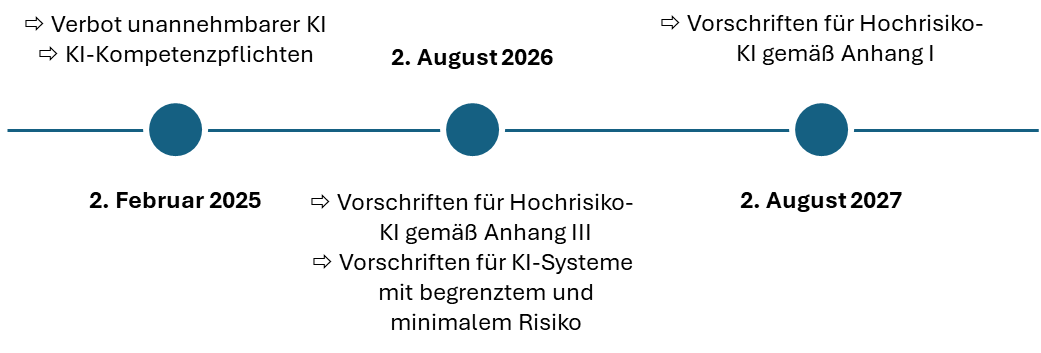

Welche Fristen müssen von Betreibern eingehalten werden?

Im AI Act sind unterschiedliche Fristen definiert, die zum einen für die Behörden selbst und die nationalen Umsetzungen gelten, aber auch für die Anbieter der großen General-Purpose KI-Systeme (GPAI). Hier eine Zusammenfassung der Fristen für die Betreiber von KI-Systemen:

Vereinfachte Zusammenfassung

Die EU hat über den EU AI Act entschieden, Pflichten und Auflagen an das Risiko zu koppeln, das von einem KI-System für Grundrechte, Gesundheit, Sicherheit oder den Rechtsstaat ausgeht:

| Risikoklasse | Beispiele | Regulatorische Pflichten |

|---|---|---|

| Unannehmbares Risiko | Social Scoring, manipulative KI | Verboten! |

| Hohes Risiko | KI im Justiz‑, Gesundheits‑, Finanz- oder Bildungsbereich | Strenge Auflagen, z.B. Schulungen, Risikomanagement, Dokumentation |

| Begrenztes Risiko | Chatbots, Deepfakes | Transparenzpflichten |

| Minimales Risiko | Produktionssteigerung, Spamfilter, Spiele-KI | Keine spezifischen Auflagen |